di Enrico Bucci e Pellegrino Conte

Vi ricordate il pane fatto con l’acqua di mare?

Qualche tempo fa le principali agenzie di stampa italiane titolarono a nove colonne che ricercatori italiani avevano scoperto che il pane fatto usando l’acqua di mare, invece che la normale acqua di rubinetto, aveva proprietà salutistiche migliori del pane tradizionale.

Ecco, per esempio, cosa scriveva il Gambero Rosso già nel 2017:

“Una nuova ricetta che consente di risparmiare acqua potabile, offrendo un alimento valido anche per chi è obbligato a seguire una dieta povera di sodio: il pane prodotto con l’acqua di mare è l’ultimo, innovativo progetto nato dalla collaborazione dei panificatori associati all’Unipan con Termomar e il Consiglio Nazionale delle Ricerche”

mentre l’ANSA nell’Aprile di quest’anno (2019) scriveva:

“Arriva il pane all’acqua di mare. E’ senza sale, ma saporito e povero di sodio”

a cui faceva seguito il sito de La Cucina Italiana che riportava:

“È iposodico e contiene il triplo di magnesio, il quadruplo di iodio, più potassio, ferro e calcio. Adesso viene distribuito anche nei supermercati”

Anche il National Geographic ha riportato la notizia scrivendo che:

“Lo ha prodotto il CNR, contiene meno sale rispetto a un filone prodotto con acqua dolce, ed è più ricco di iodio, magnesio e potassio”

Insomma un tripudio alla genialità italiana che ha confermato il luogo comune secondo cui siamo un “popolo di eroi, di santi, di poeti, di artisti, di navigatori, di colonizzatori, di trasmigratori” e … di scopritori.

Cosa c’è di vero in tutto quello che è stato riportato dalle agenzie di stampa?

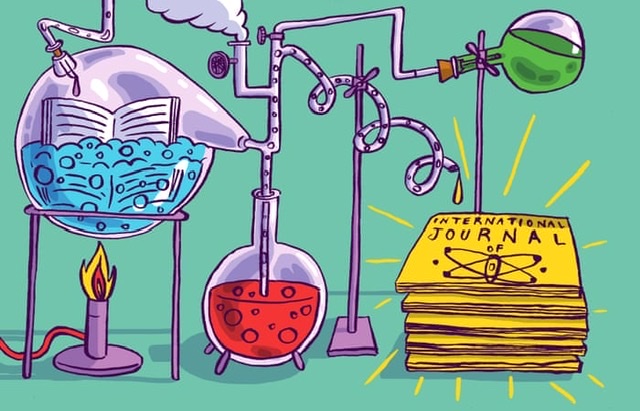

Ovviamente i giornalisti non hanno inventato nulla. È vero che un team di ricercatori italiani ha prodotto un tipo di pane usando acqua di mare e lo ha confrontato col pane prodotto in modo tradizionale ottenuto con acqua di rubinetto ed il comune sale da cucina. È anche vero che gli stessi ricercatori hanno posto un accento particolare sulle proprietà salutistiche del pane da essi “inventato” evidenziandone le qualità superiori rispetto al pane che da sempre siamo abituati a mangiare. La loro “invenzione” è stata oggetto di una pubblicazione su International Journal of Food Properties, una rivista della Taylor & Francis con un Impact Factor di 1.845 per il 2017, dal titolo: “Bread chemical and nutritional characteristics as influenced by food grade sea water”. Quello che i tutti i giornalisti e commentatori non sono stati in grado di fare è una valutazione critica dello studio pubblicato, posto che lo abbiano mai letto. Ma possiamo capire. Il loro compito non è fare valutazioni critiche di lavori pubblicati su riviste scientifiche. Sono pagati per riportare la cronaca di ciò che trovano in rete o che viene loro dato in pasto dalle agenzie di stampa degli Enti di Ricerca, come il CNR, che intendono pubblicizzare le proprie attività interne. Un pane salutistico fatto con l’acqua di mare attrae certamente l’attenzione sia verso l’Ente che ha sovvenzionato la ricerca che verso i giornali che riportano la notizia. Ma quanto c’è di vero nel lavoro che si può facilmente scaricare da questo link?

Avvertenze

Da questo momento in poi la lettura può diventare noiosa perché siamo costretti ad entrare in particolari tecnici senza i quali non è possibile rispondere alla domanda che dà il titolo a questo articolo. Naturalmente, è possibile “saltare” direttamente alle conclusioni se non avete voglia di seguire tutti i passi che ci conducono alla constatazione che lo studio pubblicato è superficiale, progettato ed eseguito male e non giustifica affatto l’esaltazione giornalistica di cui abbiamo già riportato. Ma andiamo con ordine.

Una analisi critica

Nella sezione dedicata ai Materiali e Metodi, gli autori scrivono che l’acqua di mare è stata fornita dalla Steralmar srl, una ditta di Bisceglie (in provincia di Barletta-Andria-Trani, BT). Tuttavia, una attenta lettura dell’intero lavoro evidenzia che da nessuna parte gli autori riportano la benché minima analisi chimica dell’acqua che hanno deciso di usare per la produzione del “loro” pane. Non è riportata neanche l’analisi chimica dell’acqua di rubinetto usata per la produzione del pane usato come controllo per il confronto con il pane “innovativo”. Eppure gli autori discutono delle diverse composizioni chimiche delle tipologie di pane che hanno prodotto. Basta leggere le Tabelle 1 e 2 per rendersi conto di quanto essi ritengano rilevanti le differenze in termini chimici tra i pani prodotti. Tutti i ricercatori sanno che quando si cercano differenze tra prodotti ottenuti in modo differente occorre fornire dei validi punti di partenza per poter capire se le differenze che si evidenziano sono dovute ad errori sperimentali o ai “reagenti” che si utilizzano. Ed allora: qual è la concentrazione salina dell’acqua di mare e dell’acqua di rubinetto? È presente sostanza organica disciolta in entrambe? Ed il loro pH: è lo stesso o è differente?

Il cloruro di sodio

Prendiamo, per esempio, la Tabella 1. Gli autori scrivono che il pane prodotto con acqua di rubinetto (TWB) è stato ottenuto aggiungendo 15 g di cloruro di sodio (quello che nel linguaggio comune è il sale da cucina) a 300 mL di acqua di rubinetto. Nella stessa tabella, non c’è alcuna indicazione sull’ammontare di cloruro di sodio contenuto nei 300 mL di acqua di mare usata per fare il “pane all’acqua di mare” (SWB). Nonostante ciò, gli autori concludono che il pane SWB contiene meno sodio rispetto a quello TWB e ne suggeriscono l’uso nelle diete iposodiche.

Ma per entrare nel merito, proviamo a fare quelli che vengono indicati come “i conti della serva”.

15 g di cloruro di sodio (NaCl) contengono 5.9 g di sodio (diciamo che nel pane TWB ci sono circa 6 g di sodio). L’acqua di mare contiene in media circa 27 g kg-1 di NaCl. Dal momento che la densità media dell’acqua di mare è di circa 1.02 g mL-1 a 4 °C, ne viene che la quantità di cloruro di sodio in 300 mL di acqua di mare corrisponde a 8.3 g. Nei circa otto grammi di cloruro di sodio sono contenuti circa 3 g (3.2 g, per la precisione) di sodio.

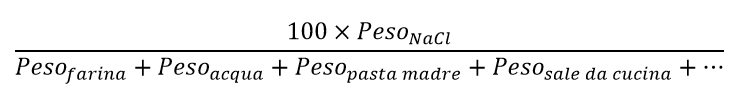

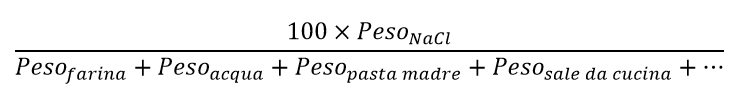

In termini percentuali, il contenuto in cloruro sodio per ogni panello non ancora cotto si calcola come:

che per il pane TWB restituisce un contenuto di NaCl pari a 1.6% (ovvero circa 2%), mentre per il pane SWB dà un valore di 0.86% (ovvero un po’ meno dell’1%).

Se, tuttavia, teniamo conto di tutti i possibili sali presenti nell’acqua di mare (la salinità dell’acqua di mare, che NON è dovuta solo al cloruro di sodio – ricordiamo che nel linguaggio chimico, il termine “sale” si riferisce a composti ottenuti per reazione tra un acido e una base – è di circa 35 g kg-1) e che essi non vengono rimossi durante la preparazione del pane, si ottiene che il pane SWB ha un contenuto salino pari a 1.1%.

In base ai contenuti di acqua riportati dagli autori per entrambi i tipi di pane (32.4% e 32.5% per TWB e SWB, rispettivamente), se ne ricava che il contenuto salino per TWB e SWB, come riportato nella Tabella 2 dello studio che stiamo valutando criticamente, non dipende da come il pane viene preparato e cotto, bensì dalla quantità di sale che gli autori decidono scientemente di aggiungere. In altre parole, considerando che l’acqua di mare contiene meno cloruro di sodio di quanto usato per la produzione del pane con la tecnica tradizionale, ne viene che il pane SWB ha meno sodio di quello TWB. Ma gli autori non avrebbero potuto ottenere lo stesso pane tradizionale iposodico aggiungendo meno sale da cucina nel loro preparato di controllo? Per esempio, se avessero preparato un pane tradizionale usando 11 g di cloruro di sodio, invece che i 15 g descritti, avrebbero ottenuto un pane TWB identico, per quanto riguarda il contenuto sodico, a quello SWB. Perché non l’hanno fatto?

Il contenuto di sodio e gli errori analitici

Centriamo la nostra attenzione sui dettagli della Tabella 2. Qui gli autori scrivono che hanno rilevato 1057 e 642 mg di sodio nel pane TWB ed in quello SWB, rispettivamente. Tuttavia, alla luce dei “conti della serva” fatti prima, il contenuto di sodio in TWB avrebbe dovuto essere molto di più (ricordiamo che ci dovrebbero essere circa 6 g, ovvero 6000 mg, di sodio in TWB). Cosa è accaduto? Si è perso cloruro di sodio durante la cottura? Come mai? E come mai gli autori non ritengono che possa essere accaduto lo stesso per il pane SWB? La cosa più grave, tuttavia, a nostro avviso è che gli autori riportano quattro cifre significative per il contenuto di sodio in TWB e tre per quello contenuto in SWB senza alcun accenno di errore sperimentale (per il significato di cifre significative e propagazione dell’errore sperimentale si rimanda al seguente link). Senza l’indicazione dell’errore commesso durante gli esperimenti, 1057 e 642, sebbene possano apparire diversi in termini matematici, sono, in realtà, lo stesso numero.

In realtà, dobbiamo anche ammettere che se guardiamo la Tabella 3, gli autori riportano che il contenuto di sodio in SWB è pari a 6492 mg kg-1 (quattro cifre significative senza errore. Significa che 6492=6500=6400=6300 etc. etc. SIC!) mentre quello in TWB è di 10570 mg kg-1 (cinque cifre significative senza errore. Significa che 10570=10600=10500=10400 etc. etc. SIC!).

Tralasciando per il momento la scorrettezza con cui gli autori riportano i loro risultati ed assumendo che quei valori siano verosimili, ne viene che dalle analisi svolte, il pane ottenuto mediante l’uso di acqua di rubinetto contiene circa 11 g di sodio. Dal momento che i “calcoli della serva” ci dicono che il contenuto di sodio aggiunto in TWB è di circa 6 g, ne viene che circa 5 g di sodio provengono dagli altri ingredienti usati per la produzione del pane.

Andiamo a vedere qual è il contenuto di sodio in SWB. Gli autori dichiarano di aver rilevato circa 7 g di sodio (6492 mg sono appunto 6.5 g ovvero circa 7 g) a fronte dei 3 g di sodio ottenuti dai “calcoli della serva”. La differenza di 4 g è attribuibile ai materiali usati per la panificazione.

La differenza tra sodio aggiunto e sodio trovato in TWB e SWB evidenzia, semmai ce ne fosse stato bisogno, l’importanza nel riportare correttamente gli errori nella valutazione quantitativa dei parametri necessari a distinguere tra prodotti ottenuti usando materiali di partenza identici tranne per l’acqua usata per la panificazione.

Si potrebbe dire: “va bene. In un caso il materiale di partenza fornisce 5 g di sodio, nell’altro 4 g. La differenza di 1 g rientra nell’ambito di un errore sperimentale”.

In realtà non è così.

Gli autori riportano chiaramente che il sodio trovato in TWB è pari a 10570 mg kg-1, ovvero per ogni chilogrammo di pane ci sono 10.570 g di sodio. Dai calcoli sopra riportati, il contenuto di sodio aggiunto è 5.9 g. La differenza è 4.67 g. Nel caso di SWB la differenza tra sodio trovato (6.492 g) e sodio aggiunto (3.2 g) equivale a 3.292 g. Alla luce di quanto finora illustrato ne viene che a parità di materiale (ricordiamo che la differenza tra i pani prodotti è solo nella tipologia di acqua) in un caso il contributo al contenuto di sodio è più alto che nell’altro. Chissà perché in TWB, il contenuto di sodio dovuto al materiale usato per la panificazione è più alto di 1.378 g rispetto a SWB.

Le domande, a questo punto sorgono spontanee: come mai gli autori non hanno fatto una adeguata analisi degli errori sperimentali? Come mai non hanno preparato un pane completamente privo di sale da usare come controllo? Come mai non hanno preparato un pane del tipo TWB con un contenuto più basso di cloruro di sodio da usare come controllo? Come mai non hanno usato acqua di rubinetto proveniente da acquedotti diversi per produrre pane con caratteristiche differenti da confrontare con quello preparato con acqua di mare?

Ancora sull’analisi degli errori

I lettori attenti potrebbero obiettare alle cose che abbiamo scritto che non è vero che gli autori del lavoro non hanno riportato gli errori sperimentali. Lo hanno fatto. Infatti, nella Tabella 3, per esempio, è scritto che il contenuto di sodio in TWB è pari a 10570.000 ± 2.7320 mg kg-1. Insomma, per essere sicuri delle loro conclusioni e per sembrare più scientifici, gli autori hanno riportato un errore con ben quattro cifre decimali e cinque cifre in totale.

La teoria degli errori ci insegna che quando si riporta il valore numerico di una qualsiasi grandezza fisica, il numero di cifre che si possono usare non è quello che viene ottenuto dalla calcolatrice, bensì bisogna fermarsi alla prima cifra contenente l’errore. Facciamo un esempio prendendo proprio quanto scritto dagli autori dello studio sotto esame. Essi hanno scritto che il contenuto di sodio in TWB è 10570.000 ± 2.7320 mg kg-1. Stanno dicendo, in altre parole, che tutte le cifre indicate in grassetto (10570.000) sono affette da errore. In base alla teoria degli errori che tutti quelli che hanno affrontato studi scientifici conoscono (anche gli autori dello studio sotto indagine dovrebbero conoscere la teoria degli errori. Ma evidentemente non è così), il modo corretto per riportare il contenuto di sodio è: 10570 ± 3 mg kg-1. Queste considerazioni si applicano a tutte le cifre riportate in Tabella 3.

I limiti dell’analisi statistica

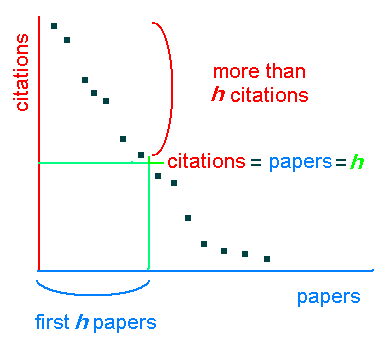

Gli autori hanno pensato bene di fare un’indagine statistica (Principal Component Analysis, PCA) che hanno riportato nella Figura 1 del loro studio. In questa indagine hanno rilevato che la PCA1 risponde per il 99% dei dati sperimentali.

Tutti quelli che a vario titolo si occupano di scienza ed usano la PCA per spiegare i loro dati sperimentali sanno che una PCA in cui una sola delle componenti ripsonde per il 99% dei dati non ha alcun significato fisico. Affinché una indagine PCA possa avere un significato attendibile è necessario che i dati sperimentali vengano “spalmati” tra almeno due componenti. Infine non c’è alcuna descrizione di come sia stata fatta l’analisi PCA.

Il conflitto di interessi

Last but not least, gli autori alla fine del loro studio affermano di non avere nessun conflitto di interessi. Ma come è possibile se uno di essi lavora proprio per l’azienda che fornisce l’acqua di mare e che non avrebbe alcun interesse a che vengano fuori risultati men che positivi?

Conclusioni

Ci possiamo fidare del lavoro tanto decantato e pubblicizzato dal mondo giornalistico? Alla luce di quanto detto, no. Il lavoro è stato progettato male perché mancano un bel po’ di campioni controllo, i dati sperimentali non sono attendibili e le analisi statistiche sono prive di significato fisico. Questo è uno studio che non avrebbe mai dovuto comparire in letteratura. Purtroppo non è così. I revisori non si sono accorti dei limiti anzidetti ed il lavoro oggi è pubblicato. Esso appartiene, ora, all’intera comunità scientifica che, come abbiamo fatto noi, può scaricarlo e criticarlo nel merito evidenziando la superficialità con cui questo studio è stato, purtroppo, condotto.

Fonte dell’immagine di copertina: Wikimedia Commons