Eravamo rimasti alle riviste predatorie (qui), quelle riviste che, dietro corrispettivo di una tassa più o meno salata, pubblicano di tutto senza una seria revisione tra pari (peer review); anzi possiamo anche dire senza alcuna revisione tra pari.

Volete un esempio?

Cliccate qui e si aprirà uno studio dal titolo “Combined Effects of Ethylacetate Extracts of Propolis Inducing Cell Death of Human Colorectal Adenocarcinoma Cells”, autori: Britta Schulz, Elizabeth Smith , Richard Funden and Ulf Moosberger; rivista: J Integr Oncol 2018, 7:2 (DOI: 10.4172/2329-6771.1000207). In questo studio (citato nel numero 1274 della rivista Internazionale) si discute dell’attività anticancerosa della propoli, ovvero di una sostanza resinosa “fabbricata” dalle api, di origine vegetale e ritenuta la panacea di ogni male. Cosa c’è di strano in questo lavoro? Semplicemente che si tratta di un lavoro inventato dai giornalisti del Süddeutsche Zeitung Magazin e del Süddeutsche Zeitung nell’ambito di una inchiesta (pubblicata appunto sul numero 1274 di Internazionale) in merito ai giornali predatori. Gli stessi giornalisti del Süddeutsche Zeitung Magazin e del Süddeutsche Zeitung, poi, affermano che, per non lasciar traccia di questa pseudo scienza, hanno richiesto il ritiro del lavoro. Ed infatti, qui trovate proprio la retraction, sebbene non sia per nulla indicato che si è trattato di un lavoro inventato.

È finita? Certo che no.

Cliccate qui. Potrete accedere al lavoro dal titolo “Aspirin plus Vitamin C Provides Better Relief than Placebo in Managing the Symptoms of the Common Cold” con autori: Aurelio Sessa and Michael Voelker; rivista: J Health Care Prev 1: 102. Cosa ha di strano questo lavoro? Semplice. Lo studio è stato condotto usando la ben nota Aspirina© C Plus contro un placebo fatto di banale acqua gassata. La prima è risultata migliore della seconda nel trattamento dei sintomi del raffreddore. Il punto è che lo studio è incompleto. Per poter essere valido oltre ogni dubbio, gli autori avrebbero dovuto usare un campione controllo a cui somministrare la normale Aspirina©, quella che in farmacia ci costa pochi euro. Perché non l’hanno fatto? Semplicemente perché avrebbero dovuto riportare che gli effetti della costosa Aspirina© C Plus sono gli stessi della più economica Aspirina©.

In questo caso si parla di dati e lavori apparsi su riviste di editori che sono inclusi nella Beall’s list of predatory journals and publishers per cui, sapendo che la serietà di tali riviste è opinabile, uno scienziato serio si guarda bene dal prenderli in considerazione se non dopo essere entrato approfonditamente nel merito di quanto lì scritto ed aver fatto un’accurata revisione post pubblicazione (ricordo che il principio fondante del metodo scientifico si basa sull’importanza di ciò che viene detto e non su quella del contenitore dove viene pubblicato un lavoro. Ne ho parlato anche qui).

Le sciocchezze nelle riviste più accredidate: il caso del gruppo editoriale Nature

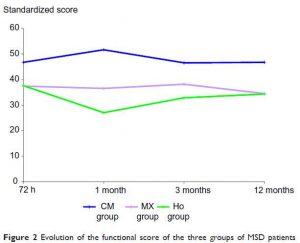

Bisogna ammettere che lavori dalla dubbia o inesistente serietà possono essere pubblicati anche su riviste più accreditate. Ne volete un esempio? Eccolo (qui). Si tratta di un lavoro sull’efficacia dell’omeopatia pubblicato su Scientific Reports (una rivista del gruppo editoriale Nature) che tutti i siti pro-omeopatia e tutti i quelli che pensano che l’omeopatia abbia un’efficacia più alta del placebo si affannano a pubblicizzare come pubblicata sulla molto più quotata Nature (qui e qui, per esempio). Cosa ha di strano questo lavoro?

Lo story-telling

Faccio una premessa. Le riviste del gruppo Nature hanno una particolarità: gli articoli sono scritti come se fossero una specie di story-telling. In altre parole, si privilegia la narrazione dei risultati e della loro interpretazione rispetto alla parte tecnico-sperimentale, ovvero l’elencazione dei materiali e metodi usati per gli esperimenti. Non fraintendetemi. Non è che materiali e metodi manchino; ci sono, solo che vengono inseriti in coda all’articolo pubblicato. Questo vuol dire che chi legge spesso si sofferma solo sullo story-telling senza approfondire oltre le modalità con cui sono stati condotti gli esperimenti. Questo modo di esporre una ricerca è positivo perché permette la comprensione di un articolo scientifico ad un pubblico molto più ampio di quello che accede a riviste che non usano il medesimo approccio narrativo: i lettori non si distraggono con particolari tecnici che, molte volte, risultano ostici ed incomprensibili. Il punto è che proprio nei materiali e metodi si annidano le insidie. È dalla lettura di quei paragrafi molto tecnici che si può capire se un progetto sperimentale è stato ben congegnato.

I dettagli tecnici

Andiamo nei particolari. A pagina 9 è scritto:

Drug treatment and groups. Animals were randomly divided into five groups, each consisting of 8 rats (n = 8). Group I: Normal control group of rats were orally administered once daily with 1 ml saline for 14 days. Group II: Sham operated group of rats were treated with 1 ml saline once daily for 14 days. Group III: CCI-induced neuropathy control group of rats orally received 1 ml saline once daily for 14 days. Group IV: CCI-induced neuropathy + RT treated group of rats orally received 0.1 ml of RT (1 × 10−12 dilution) with 1 ml of distilled water once daily for 14 days. Group V: CCI-induced neuropathy + gabapentin treated group of rats orally received Gabapentin (60 mg/kg/day, p.o.) suspended in 0.5% carboxymethyl cellulose (CMC) once daily for 14 days.

Da quanto riportato, si capisce che si tratta di una sperimentazione fatta su ratti divisi in 5 gruppi ognuno contenente 8 individui. Già da questo si potrebbe argomentare che 8 individui non sono una popolazione statisticamente significativa. Per poter avere dati che abbiano un significato statistico accettabile bisogna andare su numeri più grandi. Ed in effetti gli autori sembrano essere coscienti di questo limite perché a pagina 7 (nelle conclusioni del lavoro) scrivono:

Although, the results of present study suggested the anti-neuropathic effect of RT, further pre-clinical and clinical studies are warranted to confirm these effects. Several other biochemical mechanisms may be involved in RT mediated anti-neuropathic effect. Results of present study are suggestive of the anti-nociceptive effect of RT against neuropathic pain and deserve further validation of its effectiveness in various painful conditions.

In altre parole, occorrono esperimenti più approfonditi per validare le loro conclusioni.

La sperimentazione in cieco

Ma torniamo al “Drug treatment and groups”. Riuscite a notare cosa manca? Manca la sperimentazione in cieco. In altre parole, i trattamenti somministrati ai ratti dei cinque gruppi sono stati condotti in modo tale da non evitare né l’effetto Rosenthal né l’effetto Hawthorne. Si tratta di due possibili meccanismi dell’effetto placebo che ho già avuto modo di descrivere qui (ne parlo anche nel mio libro). La conclusione è che, sebbene pubblicato su una rivista prestigiosa di una casa editrice molto antica ed altrettanto prestigiosa, il lavoro non è fatto bene e le conclusioni non consentono di dire che i rimedi ad elevata diluizione sperimentati sono più efficaci dei placebo.

Altri esempi di lavori superficiali su riviste accreditate

Una delle riviste del mio settore è Journal of Chemical Ecology. È una rivista con un impact factor di 2.419 per il 2017. Certo non è paragonabile a quello di Nature che è 42, ma stiamo parlando di riviste scientifiche di carattere differente. Nature è una rivista generalista e, per questo, letta da scienziati di ogni settore disciplinare; Journal of Chemical Ecology è un giornale di chimica ecologica ed è destinato ad una nicchia molto piccola di scienziati, ovvero chimici che si occupano di ecologia ed ecologi. Da qui discende che il numero di citazioni che possono ricevere i lavori di Nature è di gran lunga più alto di quello che possono ricevere i lavori di Journal of Chemical Ecology destinato ad un settore enormemente più piccolo di quello di Nature (ricordo che l’impact factor è un parametro quantitativo che si calcola confrontando il numero di citazioni di tutti gli studi pubblicati in un biennio col numero totale di studi pubblicati nello stesso biennio. Per esempio, supponiamo che il numero di citazioni di tutti gli studi pubblicati su una rivista nel biennio 2015-2016 sia 13000, mentre il numero di studi pubblicati nello stesso periodo sia 5000. L’impact factor si ottiene dal rapporto 13000/5000, ovvero esso è 2.6).

Fatta questa premessa doverosa per evitare che i non addetti ai lavori si mettano a fare confronti idioti tra riviste che non possono essere confrontate tra loro (e vi assicuro che stupidi che fanno questi confronti ce ne sono), vediamo cosa mi è capitato sotto le mani.

Le cifre significative

Chi mi legge da un po’ di tempo sa che non scrivo solo per il mio blog, ma anche per altri siti come Laputa e Chimicare. In quest’ultimo ho pubblicato un breve articolo sulla matematica elementare nella chimica. Lo potete trovare qui. Non voglio tediarvi con troppi dettagli. L’articoletto sulla matematica elementare per la chimica descrive il numero esatto di cifre che si deve utilizzare per esprimere il valore numerico di una grandezza fisica e il modo con cui si esprime l’errore sperimentale:

- Sono cifre significative tutte le cifre non nulle presenti nel numero che esprime la misura sperimentale

- Lo zero compreso tra numeri non nulli è una cifra significativa

- Gli zeri che seguono numeri non nulli sono anch’essi cifre significative

- Lo zero all’inizio del numero che esprime la misura sperimentale non è una cifra significativa

- Tutti gli esponenziali in un numero espresso in forma scientifica non sono cifre significative

- Se la prima cifra non significativa è <5, il valore dell’ultima cifra significativa rimane inalterato (1.03, con 3 cifra non significativa, viene approssimato a 1.0; un errore del tipo 0.012, con 2 non significativo, viene approssimato a 0.01)

- Se la prima cifra non significativa è >5, il valore dell’ultima cifra significativa viene approssimato per eccesso (1.06, con 6 cifra non significativa, viene approssimato a 1.1; un errore del tipo 0.016, con 6 non significativo, viene approssimato a 0.02)

- Se la prima cifra non significativa è =5, il valore dell’ultima cifra significativa resta inalterato se è un numero pari o 0, viene approssimato per eccesso se è un numero dispari (1.05, con 5 non significativo, viene approssimato a 1.0; 1.25, con 5 non significativo, viene approssimato a 1.2; 1.15, con 5 non significativo, viene approssimato a 1.2; un errore del tipo: 0.015, con 5 non significativo, si approssima a 0.02; un errore del tipo: 0.025, con 5 non significativo, diventa: 0.02)

Gli errori in Journal of Chemical Ecology

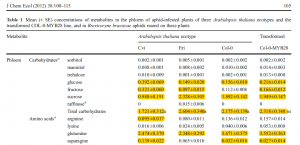

Ed eccoci arrivati al dunque. Nel 2012 appare su J Chem Ecol un articolo dal titolo “Herbivore-Mediated Effects of Glucosinolates on Different Natural Enemies of a Specialist Aphid” (qui). Non voglio porre l’attenzione sulla natura del lavoro, ma sul modo con cui gli autori (un insieme di entomologi, agronomi ed ecologi) hanno espresso i loro dati sperimentali. La Figura 1 riporta uno stralcio della Tabella 1 del lavoro citato.

In giallo ho evidenziato gli errori commessi dagli autori nel riportare il numero di cifre significative e i relativi errori sperimentali per le concentrazioni delle molecole indicate nella prima colonna a sinistra della tabella. Se aprite il lavoro (qui) potete divertirvi voi stessi a trovare gli errori commessi dagli autori nella restante parte della tabella, alla luce delle indicazioni che ho dato poco più sopra. Come possiamo ritenere affidabili le conclusioni di un lavoro scientifico se chi l’ha scritto si macchia di superficialità nell’esprimere i valori numerici delle grandezze che misura? Perché dovrei ritenere superficiale una parte del lavoro e non superficiale un’altra parte del lavoro? Devo dire che quando opero come revisore nei processi di peer review, gli errori che ho appena mostrato sono quelli che mi fanno rifiutare i lavori per la pubblicazione: se io insegno e pretendo dai miei studenti il rigore scientifico che si palesa anche, ma non solo, nella correttezza con cui si effettuano le misure e si riportano i dati sperimentali, pretendo analoga coerenza sia da me che dai miei colleghi che, come professionisti, siamo chiamati ad essere di esempio per le generazioni che ci sostituiranno nel nostro ruolo e nel mondo della ricerca scientifica.

Come è possibile che certi lavori arrivino ad essere pubblicati?

La risposta alla domanda è che anche noi scienziati siamo umani. Prima di tutto non siamo esperti di tutto lo scibile. Se un lavoro che deve essere sottoposto alla revisione tra pari arriva nelle mani di un non esperto del settore, la correttezza professionale dovrebbe imporre di non accettare l’incarico per la revisione. Ma non sempre accade. Anzi, più spesso di quanto si creda, accade che i lavori vengano revisionati da non esperti che non si dichiarano tali o addirittura da amici degli autori che chiudono entrambi gli occhi di fronte ad errori palesi. Quando ciò accade, un lavoro riesce ad essere pubblicato anche su una rivista prestigiosa semplicemente perché chi doveva accorgersi degli svarioni, o ha scientemente evitato le critiche oppure non aveva gli strumenti adatti per poterlo fare. A questo punto la domanda che una persona comune che non si occupa di scienza si può fare è: ma come faccio a fidarmi della letteratura scientifica? Se non si è preparati in modo adeguato, non ci sono molte possibilità per riconoscere un lavoro fatto bene, da uno pasticciato. L’unica arma che un lettore comune ha per distinguere la buona scienza da una scienza fatta male (o pseudo scienza) è il fattore tempo. Quando un lavoro viene pubblicato non passa inosservato. C’è sempre uno scienziato in un qualche laboratorio in giro per il mondo che si appropria dei dati pubblicati e cerca di riprodurli. Se nonostante tutti i tentativi non ci riesce, pubblica una nota in cui evidenzia l’inconsistenza dei dati riportati in letteratura. La confutazione/approvazione di un dato sperimentale pubblicato richiede tanto tempo e tanta pazienza, ma alla fine il protocollo che noi indichiamo come “metodo scientifico” consente di fare una cernita tra dati seri e dati meno seri: è capitato con i lavori di Wakefield, Schoen e tanti altri di cui ho già parlato qui.

Adesso, però, vi ho annoiato anche troppo. Il reportage continua la prossima settimana.

Fonte dell’immagine di copertina: qui